Добрый день дорогие друзья, сегодня большой пост про полный аудит сайта или как вижу его я. Акцент будет направлен именно на бесплатный аудит сайта, потому что многие читатели не владеют лишними средствами и ресурсами для полного внешнего и внутреннего аудита сайта. Поэтому будем выкручиваться подручными и бесплатными программами/сервисами.

Многие моменты я уже описывал раньше, например в статье про бесплатный анализ сайта или 10 must have факторов на сайте. Но это всё были маленькие и узко-тематические статьи, а в этом посте я хочу собрать все работающие способы для максимально полного аудита сайта.

Подготовка к Seo аудиту сайта

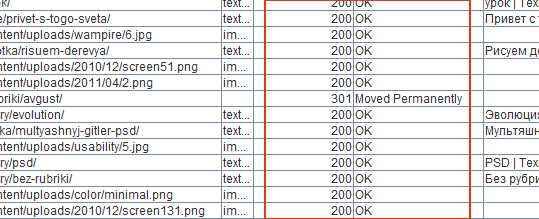

Первым делом, надо просканировать все страницы сайта, чтобы иметь представление о количестве страниц, структуре и получить данные о доступности, редиректах и.т.п.

Есть несколько хороших способов просканировать сайты:

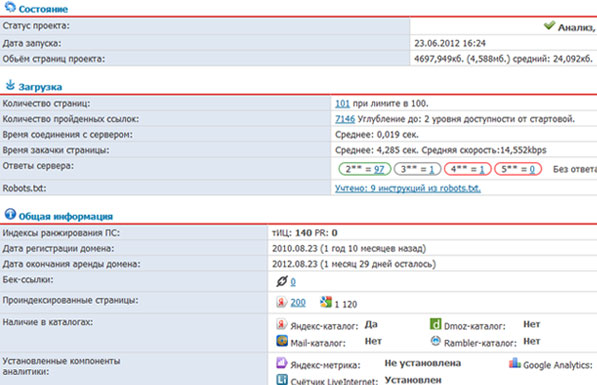

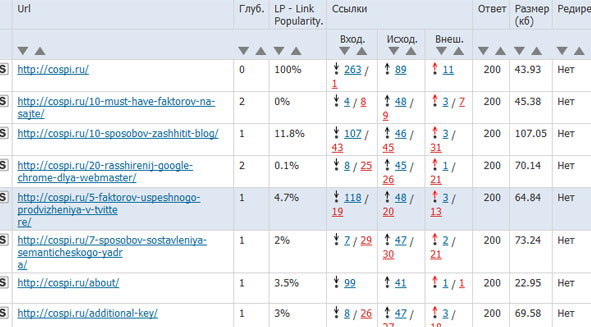

- Если сайт маленький (до 100 страниц), то можно бесплатно просканировать его на сервисе сайтрепорт.рф

Если сайт имеет больше 100 страниц, то платная проверка будет стоить 10 копеек за страницу. Просканировать сайт в 500 страниц, вам обойдётся в 50 рублей.

В отчёте вы получаете:

- Основные данные по сайту (ТИЦ, PR, нахождение в каталогах, возраст домена);

- Список страниц (в бесплатном варианте первые 100);

- Основные данные по страницам (доступность, title, description, размер);

- Список внутренних и внешних ссылок для каждой страницы.

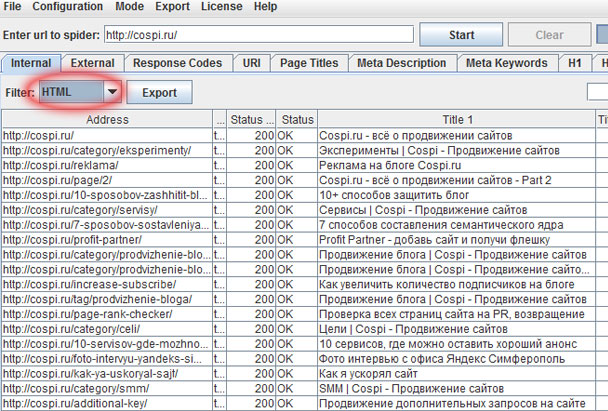

Сервис предоставляет очень много информации по всем страницам сайта. К тому же данные удобно оформлены и легко разобраться.Просканировать сайт, можно с помощью программы Screaming Frog – это так называемый SEO паук, который работает с вашего компьютера. Программа платная, но демо-версия позволяет проверять до 500 страниц сайта. Данные на выходе почти такие же как и у сервиса сайтрепорт.

Так же интересная настройка сканирования с определённым user-agent. Например, можно указать user-agent основных поисковиков, чтобы мы смогли увидеть глазами ПС весь сайт.

Googlebot — «Mozilla/5.0 (compatible; Googlebot/2.1; +

http://www.google.com/bot.html)"

YandexBot – «Mozilla/5.0 (compatible; YandexBot/3.0)»

3) И ещё одна программа для сканирования сайта – Xenus. Она бесплатна и даёт в принципе полную информацию о структуре сайта, доступности страниц. Я описывал эту программу в статье — Техническая оптимизация сайта.

Взять данные у Эталона

То есть у Поисковых систем. При добавлении сайта в вебмастерские панели Google и Яндекс, мы сможем получить сводную информацию о существующих ошибках на сайте и советы по их устранению.

https://www.google.com/webmasters/tools/home?hl=ru – Google

https://webmaster.yandex.ru – Яндекс

Сбор информации ещё не закончен, нам надо теперь более серьёзно проанализировать сайт и поэтому переходим уже не посредственно к внутреннему аудиту сайта.

Бесплатный аудит сайта

Грубо говоря, его можно разделить на 5 этапов:

- Доступность

- Индексация

- Внутренние факторы ранжирования

- Внешние факторы ранжирования

- Место сайта среди близких конкурентов

1. Доступность

Основные страницы сайта должны быть доступны как для простых посетителей, так и для поисковых систем. Под доступностью подразумевается – оптимальная скорость загрузки страницы, запрет индексации дублей, правильный ответ сервера для продвигаемых страниц и.т.п.

Robots.txt

К примеру, самый простой robots.txt, который разрешает полную индексацию сайта:

Обязательно проверяйте этот файл руками и смотрите на правильность заполнение. Советую прочитать статью о правильной настройке Robots.txt

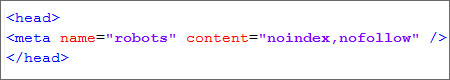

Мета-теги Robots

Если вы, например, используете WordPress и плагины для Seo оптимизации (Platinum Seo Pack и.т.п.), то надо следить за правильной настройкой плагина, потому что они часто закрывают рубрики, теги и тому подобные страницы, именно через Мета-тег robots.

В общем надо просмотреть важные страницы сайта, чтобы они случайно не были закрыты от индексации.

Коды состояния HTTP

Так называемые коды ответа сервера. Они должны быть правильными для каждого типа страниц сайта. Если это простая страницы сайта, то должен отдаваться код 200, если не существующая страница – 404, редирект – 301 или 302.

Для определения ответов сервера, пригодятся программы и сервисы, которые были описанные в самом начале страницы.

Обязательно надо убрать или восстановить страницы, которые отдают ошибки вида 4xx и 5xx.

Так же советую почитать пост — Коды заголовков HTTP, эффект в SEO.

Карта сайта

«Карта сайта» обязательно должна присутствовать и желательно чтоб она была в xml формате. Html версию «Карты сайта» можно уже не использовать, так как Яндекс, отлично индексирует xml.

Создать карту сайта можно с помощью программ и сервисов, для WordPress отлично подходит плагин

Google XML Sitemaps. Так же существует универсальная программа

SiteMap Generator.

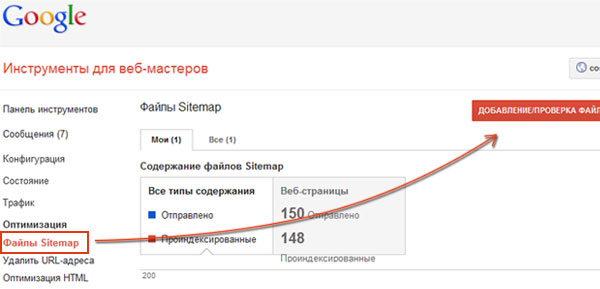

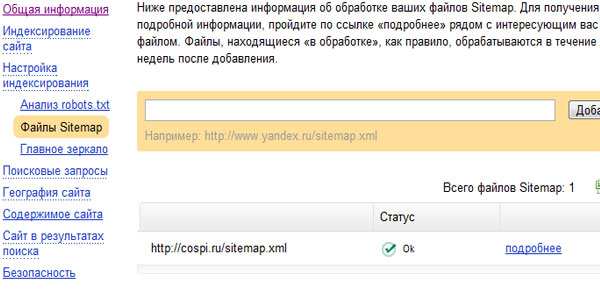

Правильную карту сайта, следует добавить в «панель вебмастера» Google и Яндекса.

Для Google – это в «Оптимизация — Файлы Sitemap – Добавление/Проверка»:

Для Яндекса – «Настройки индексирования — Файлы Sitemap»:

Архитектура сайта

Архитектура сайта во многом зависит от возможностей CMS, но всё равно надо следить за глубиной, чтобы страниц 4 ур. вложенности и более, было минимум на сайте.

Скорость загрузки сайта

В этом вопросе всё условно и нет каких-то точных рамок, всё зависит от типа сайта. Но в любом случае, надо стараться максимально уменьшать этот показатель. Получить подробную информацию о скорости загрузки сайта можно с помощью сервиса

Pingdom Full Page Test, так же можно

проверить сайт под нагрузкой.

Пример данных от сервиса Pingdom:

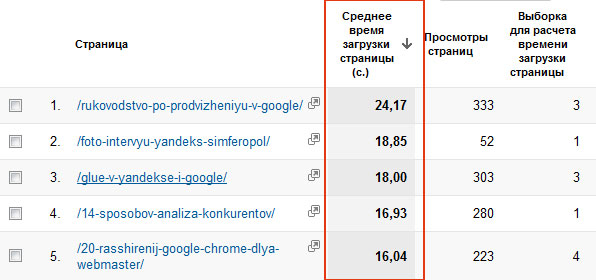

Так же много информации о скорости загрузки отдельных страниц сайта, можно получить от Google Analytics:

Эти данные вы можете найти в «Содержание — Скорость загрузки сайта — Время загрузки страниц«, после чего сделайте сортировку по времени загрузки и получите список самых тяжелых страниц сайта. Раньше я писал пост с советами по ускорению сайта, надеюсь, он вам пригодится.

2. Индексация

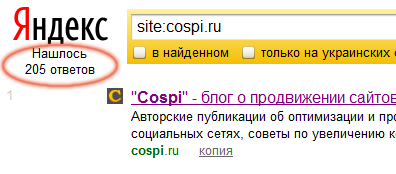

В Яндексе и Google можно определить кол-во проиндексированных страниц, с помощью команды «site:mydomain.ru»:

Сразу стоит обратить внимание на такие моменты:

Кол-во страниц в индексе фактически ровняется общему количеству страниц на сайте. Это самый лучший вариант.

Страниц в индексе меньше, чем на самом деле. Тут могут быть проблемы с доступностью сайта или наложен фильтр от ПС, например АГС.

Страниц больше, чем есть на самом деле. Скорей всего индексируется дублирующий контент (страницы поиска, архивы, теги, страницы печати и.т.п.) с которым надо бороться.

Команда «site:mydomain.ru» показывает общее количество страниц в индексе, но нам ещё надо проверить основные страницы на индексацию. Список страниц сайта мы получили, когда сканировали сайт. Проверять можно в ручную (если мало страниц) или использовать программы, я например, пользуюсь Яззлом, но она платная, из бесплатных есть программа – YACCA.

Суть этого этапа в том, чтобы определить страницы, которые могут находиться не в индексе поисковых систем и устранять эту проблему.

3. Внутренние факторы ранжирования

URL-адреса

Первым делом надо проверить, что домен доступен только в одном виде – example.com или

www.example.com. Если сайт доступен в обоих случаях, то надо обязательно склеить дублирующую версию. Для этого в файле .htaccess надо добавить вот такой код:

RewriteEngine On

RewriteCond %{HTTP_HOST} ^domain.com$ [NC]

RewriteRule ^(.*)$

http://www.domain.com/$1 [R=301,L]

Теперь будет доступна одна версия сайта с www.

Так же, следует проверить ЧПУ и стараться создавать понятные и короткие адреса, для продвигаемых страниц. Существует мнение, что лучше не использовать нижнее подчёркивание между словами в урл, вместо него использовать дефис – почитайте

перевод лекции Мэтт Каттс на эту тему.

Этот пункт скорей всего надо выполнять в момент запуска сайта, потому что менять url, уже у не молодого сайта с какими-то позициями — не стоит. Так как минимум на 2-3 месяца пропадёт трафик с Яндекса, да и на все 100% позиции не восстановятся после склеивания старых url с новыми.

Продвигаемые страницы следует проверить на:

Уникальность контента. Для этого подойдёт программа Advego Plagiatus, с помощью которой можно определить уникальный текст или нет.

Орфографию. Корректность продвигаемых текстов надо проверить обязательно, можно с помощью

сервиса Яндекса.

Ключевые слова. Проверка правильной оптимизации текста – ключевое слово в <title>, тегах <h1>, <h2>. Быстро проанализировать текстовую часть страницы, можно с помощью сервиса Browseo, а так же советую почитать пост про оптимизацию контента.

Дублирование контента. Индексируемые дубли страницы, очень вредны для сайта, поэтому надо закрывать их от индексации. Дублями могут быть страницы поиска, печати и.т.п. Дубли я проверяю руками, то есть ввожу кусочек текста в поисковую строку и смотрю, что находит ПС. Только не забывайте искать в кавычках, чтоб поисковик искал «точные» вхождении.

Html разметка. Обязательно проверяем валидность

html кода и

CSS.

Изображения. Для поисковых систем надо прописывать alt и title изображения, чтобы они понимали о чём она.

Исходящие ссылки. Надо проверить на кого ссылается сайт, если сайт плохого качества или например не работает, то ссылку следует убрать. При сканировании программой Xenus, в отчёте указываются исходящие ссылки, на сайты, которые не доступны.

Внутренняя перелинковка

Большинство НЧ запросов можно вывести в ТОП, благодаря перелинковке и хорошо написанному тексту.

Стоит обратить внимание, на такие вещи:

Присутствуют ссылки в теле статьи (контекстные)? Один из наиболее лучших способов линковки, когда тематическая статья ссылается на продвигаемую страницу.

Установлены блоки «Похожие или случайные записи/товары»? Чаще всего служит как дополнение к внутри текстовой перелинковке.

Есть ли естественные анкоры ссылок? Помимо точных вхождений ключевых слов, надо ещё использовать все возможные формы «ключевого слова».

4. Внешние факторы ранжирования

Основные показатели сайта. Оцениваем ТИЦ и PR, как базовые данные о примерном состоянии ссылочной массы сайта.

Проверка обратных ссылок. Из условно бесплатных сервисов, можно воспользоваться

ahrefs и

solomono. Следует учитывать и количество естественных ссылок на сайт, если их мало (меньше 20% от общего числа), то надо поработать над увеличением естественной ссылочной массы – особенно актуально в мире seo постпингвинного периода ![]() .

.

Анализ трафика на сайт. В этот пункт входит анализ трафика с поисковых систем и её тенденция изменения в последние месяцы, по основным счётчикам (Li, Яндекс Метрика, Google Analitics).

Из внешних сервисов — анализ трафика по Alexa.com.

5. Место сайта среди близких конкурентов

Одним из важных составляющих seo аудита, является определение положение сайта в конкурентной выдаче, то есть по каким запросам он уже есть в ТОПе и что из себя представляют основные конкуренты.

Лучше всего составить табличку с имеющимися запросами, которые уже приносят трафик, для дальнейшей работы с ними. Я подробно описывал, как искать и проверять имеющиеся запросы, в статье «Продвижение дополнительных запросов на сайте«.

Анализировать конкурентов можно примерно так же, как мы проводили аудит сайта в этой статье.

Отчёт по аудиту

Важную информацию по аудиту сайта, я обычно оформляю в Excel файле с несколькими страницами.

На первой странице указываю основную информацию по сайту:

На второй странице, список запросов, которые уже присутствуют в ТОПе, с релевантными страницами:

Далее я указываю проблемные страницы, у которых допустим неправильный ответ сервера, битые ссылки, отсутствуют мета теги или заголовки. В самом конце записываю то, что надо сделать по сайту, чтобы в будущем было проще вспомнить проблемные места.

Что вы думаете?

Наконец-то закончил писать эту статью, получилось больше 12 тысяч знаков, сколько дней я её писал – уже и не помню ![]() .

.

Мне очень интересно знать, что вы думаете, о такой схеме условно бесплатного аудита сайта? На этом всё, спасибо за внимание и пишем в комментариях!