Оглавление:

Фильтры за возраст сайта:

Фильтры за манипуляцию с внутренними факторами:

- Google Florida

- Сопли

- Google Omitted Results

- Google Duplicate Content

- Brocken Links Filter

- Page Load Time Filter

Фильтры Google за манипуляции ссылками:

- Google Bombing

- Google -30

- ReciprocalLinksFilter и LinkFarming Filter

- Co-Citation Filter

- To Many Links at Once Filter

Фильтры за возраст сайта:

DNA

Фильтр на недавно зарегистрированные домены DNA (Domain Name Age). Накладывается на «молодые» домены. Для того, что б сайт на недавно зарегистрированном домене смог подняться в топе Googl`а, нужно завоевать «доверие» у системы Google.

Выход из под фильтра:

- Просто подождать;

- Набирать так называемый траст, поставить на себя ссылки со старых тематических сайтов.

Песочница (или по научному SandBox)

Под фильтр песочница попадают молодые сайты. Основная причина заключается в низком доверии поисковика к сайту. От DomainNameAge, SandBox отличается тем, что под него могут попасть сайты на старых доменах, если эти сайты плохо или совсем не обновляются, не обрастают бэклинками и у них низкий уровень посещаемости.

Выход из под фильтра:

- Наращивание естественных ссылок с тематических сайтов;

- Развивать проект дальше.

Фильтры Google за манипуляции с внутренними факторами

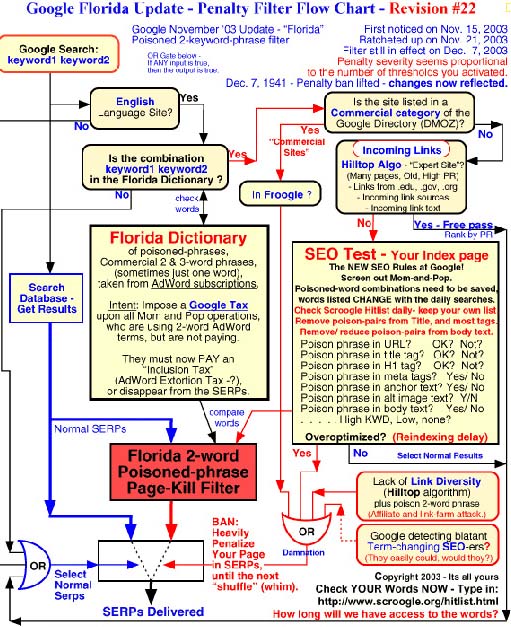

Google Florida

Фильтр за чрезмерное использование инструментов оптимизации страницы. Один из самых старых фильтров использующий множество параметров для анализа.

Причина наложения фильтра — неправильная внутренняя оптимизация сайта (слишком частое употребление «ключевиков» в тексте, чрезмерное выделение ключевых слов тегами и т.д.).

Последствия — сайт существенно теряет позиции в выдаче.

Выход из под фильтра — заменить всю сео-оптимизированную текстовку на хорошо читаемую (сократить плотность вхождений ключевых слов и фраз). Если не помогает, то на страницах попавших под фильтр оставьте только одно прямое вхождение ключа. Вот так выглядел алгоритм Флориды:

Очень страшно и не понятно ? Сейчас этого фильтра как такового нет, он существовал 7 — 5 лет назад, после чего Гугл его прикрыл, поняв его не состоятельность, ведь фильтр накладывался на определённые страницы, а не сайты и по этому оптимизаторы создавали по несколько версий сайта, одна часть переоптимизирована, а другая недооптимизирована, чтоб обмануть алгоритм этого фильтра. Сейчас работает более лояльная модификация этого фильтра, который уже по ювелирному оценивает содержимое страницы.

Google Supplemental Results или просто Сопли

Перенос сайта из основного раздела в дополнительные разделы поиска. Проверить можно таким способом — Посмотреть основную выдачу таким запросам:

844потом посмотреть всю выдачу:

Разница между запросами 2 и 1 будет ровняться количеству страниц находящимися под фильтром.

Выход из под фильтра:

- Удаление повторяющихся страниц;

- Уникализация каждой отдельно взятой страницы;

- Покупка на зафильтрованные страницы трастовых ссылок;

- Уникализация title и мета-тегов; * — самое главное

- Написать полностью уникальный контент; * — самое главное

- Убрать битые ссылки.

У Шакина например половина страниц под соплями и не смотря на это, с Гугла идёт хороший трафик.

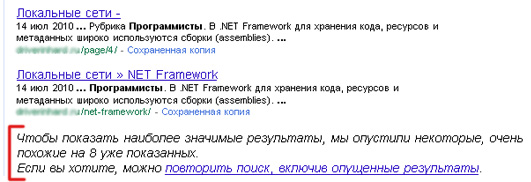

Google Omitted Results

Перенесение сайта из основного раздела выдачи в опущенные результаты поиска Налаживается на страницы, которые по своей структуре и содержанию очень схожи со страницами других сайтов или страницами этого же сайта. Может применяться одновременно с фильтром Supplemental Results.

Признаки — сайт отсутствует в основной выдаче, но он находится, после нажатия на ссылку «повторить поиск, включив опущенные результаты». Выглядит это чудо вот так:

Выход из под фильтра:

- Сделать продвигаемые страницы уникальными(контент, мета-теги);

- Удалить все дубли.

Google Duplicate Content

Фильтр за дублированный контент. Налаживается на сайты, которые не содержат уникальный контент, то есть воруют с других сайтов. Могут, конечно, наложить на сайт у которого воруют контент, такая уж суровая реальность.

Основные признаки — это падение позиций, позиции стоят на месте при активном продвижении.

Методы выхода и защиты:

- Защитить контент от воровства (практически не реально);

- Заменить ворованный контент на уникальный;

- Не воровать :).

Brocken Links Filter

Фильтр за битые ссылки. Если на сайте много битых (неработающих) ссылок, Google может понизить доверие к такому сайту и опустить его в поисковой выдаче.

Методы выхода и защиты:

- Проверить сайт программкой Xenus и удалить все битые ссылки;

- Не допускать в будущем появление их.

Page Load Time Filter

Фильтр для сайтов, которые долго загружаются. В новом алгоритме Кофеин, Google ввёл новую составляющую которая учитывается в ранжировании сайта, это скорость загрузки сайта. Её вес при расчёте релевантных страниц равняется примерно 1%.

Основные признаки — сайт упорно не может обогнать какой-нибудь сайт, может дело как раз в скорости загрузки сайта. О проверки скорости я писал в статье о Технической оптимизации сайта.

Фильтры Google за манипуляции ссылками

Google Bombing

Фильтр за одинаковые анкоры ссылок. Если на ваш сайт ссылается много сайтов и анкоры ссылок везде одинаковые, то сайт попадает под фильтр и бэки начинают передавать вес намного меньше.

Признаки — проседание позиций или застрявание сайта на одних и тех же позициях длительное время, нет результата от увеличения ссылок на ваш сайт.

Методы выхода и защиты:

- добавить в анкор-лист новых, разбавленных слов.

- Увеличить количество естественных ссылок (тут, клик и.т.п.)

Google -30

Накладывается за использование клоакинга, редиректов и других методов черной оптимизации. Признаки: падение сайта примерно на 30 позиций.

Методы выхода и защиты:

- Стараться не использовать чёрные методы продвижения;

- Если уже попали под фильтр, то скорей всего дальше будет бан.

ReciprocalLinksFilter и LinkFarming Filter

Понижающие фильтры за искусственное наращивание ссылочной массы. Накладываются за участие в сетях по обмену ссылками, наличие линкопомоек и покупку ссылок на сайте. При этом у сайта наблюдаются понижение позиций или бан.

Методы выхода и защиты:

- осторожно работать с покупкой, продажей и размещением ссылок;

- устранить причины наложения фильтра.

Co-Citation Filter

Фильтр за бэки с сайтов, ссылающихся на “плохие” сайты. В общем если на вас ссылается сайт и в то же время он ссылается на какие-нибудь ГС (запрещенные тематики и т.п.), то это плохо.

Методы выхода и защиты: — старайтесь получать ссылки только с хороших и тематических сайтов.

To Many Links at Once Filter

Фильтр за быстрый прирост бэклинков. Надо во всём соблюдать естественность и набор ссылочной массы тоже должен быть естественным, тем более для молодого сайта.

PS: Очень буду благодарен за ваш ретвит.

UP:08.01.2021

Последние годы основные фильтры у Google стали Панда и Пингвин. Первый пессимизирует сайты за использование не качественного контент, а второй соответственно, за продвижение с помощью SEO ссылок.