Первую часть вы можете найти тут. Там я писал про обработку ошибки 404 и про скорость загрузки сайта.

Вторая часть будет по больше чем первая, так как не хочется растягивать еще на одну или две статьи, всё сюда постараюсь вместить.

Robots.txt

На каждом сайте должен присутствовать этот файл. Ведь первым делом, когда бот поисковых систем попадает на ваш сайт, он смотрит этот файл. В нём мы можем закрыть не нужные страницы сайта от индексации, указать на правильный домен, поставить определённые промежутки времени, по которым боты поисковых систем будут скачивать страницы.

Создание:

Текстовый файл с названием robots.txt (именно так, ни каких заглавных букв) надо разместить в корне сайта. Если вы не хотите закрывать определённые страницы от индексации, то можете оставить его пустым.

Но все, же лучше закрыть некоторые страницы от индексации. А именно, закрыть надо все страницы, где дублируется контент: тэги, метки, архивы и.т.п. Так же закрыть системные страницы, которые не предназначены для посетителей сайта и ПС.

У себя на сайте я использую такой robots.txt:

Более подробно с правилами оформления вы можете ознакомиться на сайте robotstxt.org.ru

Карта сайта. Sitemap

Карта сайта нужна для того, чтоб Поисковый бот мог легко увидеть все страницы сайта и понять структуру. Для больших сайтов с запутанной структурой, с динамически обновляемыми данными, карта сайта просто обязательна.

На этом блоге я использую плагин Google XML SiteMap Generator для создания Карты сайта, он заточен под потребности Гугла, но Яндекс тоже его понимает.

Яндекс поддерживает два формата файлов Sitemap:

Но как написано в справке, что предпочтительнее Формат XML, поэтому не тратте время и делайте только один файл Sitemap.

Чтоб сообщить ПС о вашей карте, надо либо добавить сайт в Панель Вэбмастер как у Яндекса, так и у Google и там уже добавить Карту Сайта в соответствующем разделе. Так же прописать директиву Sitemap в файле robots.txt.

Проверка правильной доступности домена

Бывает такое, что один сайт доступен по разным адресам. Например:

Из-за этого возникает дублирование контента на сайте, к чему очень плохо относятся ПС. Проверить это можно просто, если сайт уже попал в индекс ПС то просто в строчку поиска вбиваем:

И смотрим, какие страницы проиндексированы, с каким префиксом и тому подобное. Это работает как для Яндекса, так и для Google.

Можно, просто в браузерной строке набрать сначала сайт с префиксом www, а потом без, если в обоих случаях сайт доступен, то это надо срочно исправлять.

Исправить это можно такими способами: Прописать директиву Host в robots.txt и в ней указать главный домен. Для Яндекса этого бывает достаточно, чтобы он склеил основной домен с зеркалом. Так же стоит поставить 301 редирект с зеркала на основной домен. Для этого можно в файле .htaccess указать:

RewriteEngine On

RewriteCond %{HTTP_HOST} ^domain.com$ [NC]

RewriteRule ^(.*)$ http://www.domain.com/$1 [R=301,L]

Данный пример редиректит все запросы без префикса www на главный домен — www.domain.com

Проверка битых ссылок, не существующих страниц и еще очень многое.

Всё это я делаю с помощью удобной программы Xenu, скачать можно вот

отсюда. Она анализирует сайт как в Интернете, так и на локале. Очень удобная программа, которая проводит, можно сказать, полный аудит.

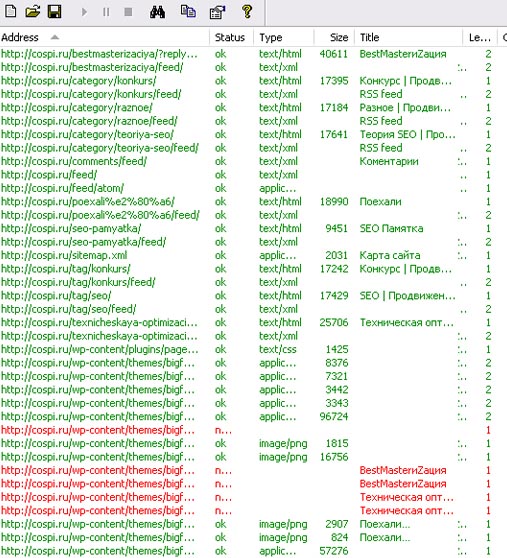

После анализа она выводит вот такую таблицу:

А именно:

- Доступность каждой страницы;

- Доступность всех ссылок (внутренних и внешних);

- Уровень вложенности страниц;

- Показывает title страниц;

- Размер документа.

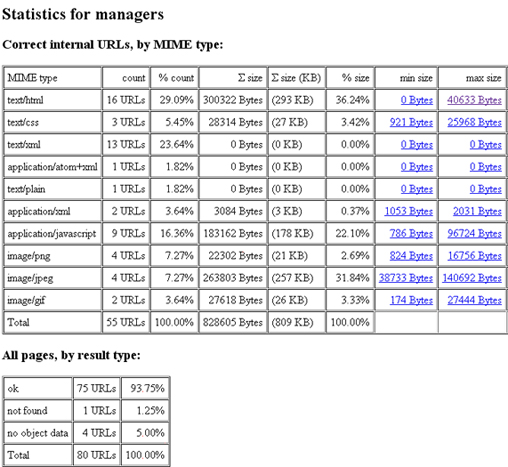

Так же программка создаёт отчёт, ниже на скриншоте показано только общая информация из него:

В отчете даётся:

- Не существующие ссылки, страницы;

- Список страниц с редиректами;

- Список нормальных страниц для ПС;

- Показывает Карту сайта, то есть структуру с Тайтлами страниц;

- Ну и общая статистика, которую вы видели на скриншоте.

Подробно о работе с программой Xenu: Поиск битых ссылок на сайте

Остальные моменты, которые надо учесть в оптимизации сайта.

— Присутствие Фавикона на сайте. Эта картинка размером 16х16 с расширением *ico. У самого его еще нету, всё думаю что там нарисовать :).

Добавить его можно так: В корень сайта закачиваете ваш фавикон и в тэгах прописываете адрес к нему вот так:

Если будете использовать этот код, то поставьте правильно кавычки все, а то у меня WP почему-то не правильно показывает кавычки… пришлось такие поставить.

— Логотип Если есть логотип на сайте, то желательно чтоб он был кликабельным и вёл на Главную страницу сайта

— Валидный код Обязательно проверти весь код на Валидность, можно проверить тут —

W3C

— Внешние ссылки Если на странице от 10 внешних открытых для индексации ссылок, то это уже будет подозрительно для ПС, особенно если сайт молодой. По возможности надо закрыть не нужные ссылки от индексации или вообще удалить. Закрыть можно тэгом и атрибутом ссылки rel=»nofollow».