Добрый день. Сегодняшнюю статью я хочу посветить такой щепетильной теме, как закупка ссылок в Sape. Речь пойдёт о фильтрации плохих доноров и выборе хороших площадок, которые точно будут передавать ссылочный вес.

Данный пост я в первую очередь подготовил для себя, чтобы постоянно была схема перед глазами, а то всё на листочках хранится :).

Введение и настройка

Отбор и сортировку площадок я выполняю с помощью плагина Винка для Mozilla Firefox и RDS Bar.

Первым делом надо настроить плагин, для этого выставляем вот такие настройки:

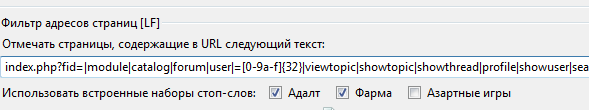

Фильтр адресов страниц

Эта функция выделяет страницы, которые включают в своём адресе не желательные комбинации — профили, форумы, страницы тегов, поиска и.т.п. Находится она в первой вкладке окна настроек. Список таких адресов у меня вот такой:

Вы можете его дополнять своими не желательными адресами.

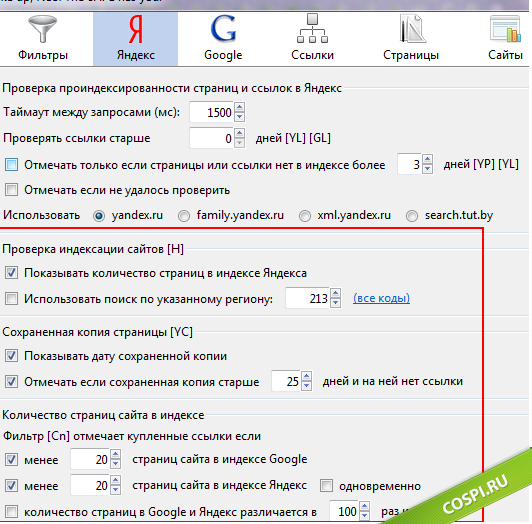

Настройки для проверки по Яндексу

На этой вкладке желательно выставить примерно вот такие настройки:

Одним из важных фильтров, является проверка на «дату сохранения страницы в кэше Яндекса». Если последний раз бот Яндекса заходил на страницу 2 – 3 месяца назад, то очень большая вероятность того, что переиндексация этой страницы будет не скоро и вам очень повезет, если ваша ссылка попадёт в индекс в течение 4 – 6 недель.

Я всегда выставляю этот показатель на 25 дней и благодаря этому, 95% купленных ссылок попадают в индекс в следующие 2-3 апа после покупки.

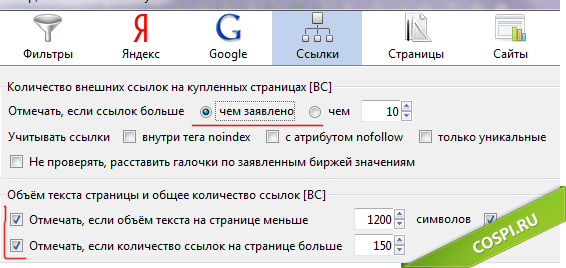

Проверка ссылок

Все настройки задаются для кнопочки [BC], при клике по ней, плагин будет отмечать страницы, у которых число внешних ссылок отличается от заявленных и контролировать объём текста на странице.

Контроль объёма текста нужен для того, чтобы отсеять ГС и интернет магазины, которые пропустил «фильтр адресов».

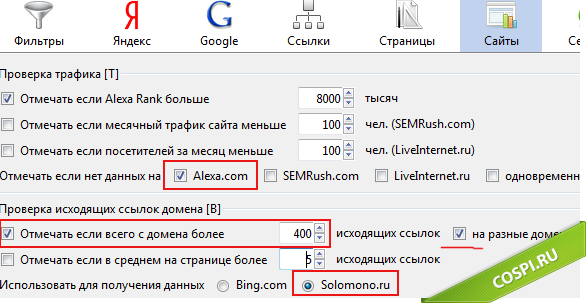

Проверка Трафика и Исходящих ссылок с домена

Общий трафик я проверяю по Alexa Rank, если он больше 8 миллионов (в настройках это как 8к), то такие сайты я отправляют в BL. Не использую фильтрацию по LiveInternet, потому что не везде счётчик стоит и чаще всего статистика закрыта и данные по посещаемости взять не реально.

Дальше идёт настройки для проверки внешних ссылок по Solomono. На этом этапе всё условно, но в среднем, чем меньше ссылок с сайта, тем лучше, особенно для наращивания ТИЦ.

Надо так же смотреть на кол-во страниц у сайта, если их несколько тысяч, то 300 – 400 исходящих ссылок вполне нормально. Но вот сайты с малым количеством страниц (100-200) и которые имеют такое же количество исходящих ссылок, будут явно заспамленными и вес передадут минимальный.

Базовая настройка плагина Винка закончена, теперь давайте перейдём к самой схеме фильтрации доноров.

Последовательность фильтрации площадок в Sape

Все эти действия, желательно выполнять последовательно, для экономии времени.

1. Проверка количества страниц в индексе

Первым делом надо удалить сайты под АГС или явно маленькие сайты которые в скором времени попадут под него, из-за продажи ссылок. В настройках у меня указан фильтр на 20 страниц в индексе.

Данные берутся по данным Sape, то есть эта проверка практически без полезна :), потому что система довольно редко обновляет статистику по добавленным сайтам. Но тем не менее, можно отсеять часть плохих сайтов.

2. Вторая проверка кол-ва страниц в индексе Яндекса

На этом этапе, плагин уже берёт данные у Яндекса и мы уже точно сможет отсеять сайты под АГС.

3. Контроль URL страниц

Теперь видно страницы, на которых нежелательно покупать ссылки.

4. Проверка трафика по Alexa Rank

Удаляем площадки с очень маленьким трафиком. Если мало площадок вашей тематики, то можно пропустить этот шаг.

5. Исходящие ссылки с домена по Solomono

Удаляем площадки с большим количеством внешних ссылок, как уже писал выше – это значение условно и иногда приходится покупать без этой проверки, к примеру когда мало тематических доноров.

6. Объём текста и ссылки на странице

Проверяем на объём текста и количество внутренних и внешних ссылок. Сайты, которые не подходят под наши настройки – удаляем в Black List.

Основной «отсев» площадок закончен, после этих шести пунктов, отсеивается примерно 70-80% найденных сайтов, в зависимости от тематики.

Теперь, когда основная часть плохих площадок удалена, можно уже проверять страницы на индекс и дату сохранения.

7. Индекс и дата сохранения

Проверять на индекс страницу [YP] после этого не надо, потому что [YC] отмечает — проиндексирована страница или нет:

Вот и всё, после этих 7 пунктов проверки и фильтрации, у вас должны остаться только хорошие площадки, которые будут передавать ссылочный вес. Дальше надо уже визуально просматривать сайты и отсеивать то, что плагин пропустил.

Я описал всё это, с уклоном для продвижения в Яндексе, для Google можно проверять то же самое, только добавить проверку на «индексацию страницы» в Google и определение PR.

На этом всё, спасибо за внимание и не забывайте про ретвит ??